本文共 3782 字,大约阅读时间需要 12 分钟。

本节书摘来自异步社区《Python和HDF 5大数据应用》一书中的第2章,第2.2节,作者[美]Andrew Collette(科莱特),胡世杰 译,更多章节内容可以访问云栖社区“异步社区”公众号查看。

2.2 设置

背景就介绍到这里。现在让我们开始使用Python!不过,用哪个Python?

2.2.1 Python2还是Python3

Python社区正在经历一场大变。多年以来Python已经积攒了一大堆功能和错误,比如不遵守命名规范的模块或者字符串处理上的缺陷等。为了解决这些问题,人们决定启动Python 3,从Python 2过去的错误中释放出一个全新的Python主版本。

Python 2.7将是最后一个2.X的发行版。虽然为了修理bug,对它的更新还会继续持续一段时间,但是新的Python代码开发工作将只在3.X上进行。NumPy、h5py、PyTables以及其他很多模块现在都支持Python 3。虽然(我认为)对新手直接推荐Python 3还有些操之过急,但未来的趋势却是已经十分明显。

目前来说,两大版本的Python还将同时存在一段时间。因为Python社区的大多数用户都已经习惯了Python 2,本书中的例子也都是以Python 2写就。两大版本在大多数地方都仅有细微差别。比如,Python 3中print的格式是print(foo),而不是print foo。在本书的任何地方,只要出现由于Python版本差异导致的不一致(主要是有关字符串类型和某些字典形式的方法),都会在文本中加以标明。

将Python 2代码“移植”到Python 3并不难,毕竟都是Python。Python 3中一些最有价值的功能其实已经存在于Python 2.7中了。有一个免费工具(2to3)可以自动完成大部分改动,比如将print语句转换成print()函数调用。你可以在 查阅移植手册(以及2to3 工具)。

2.2.2 代码示例

大多数代码示例都将遵循下面的形式:

或者是下面这样更加简单的形式(得益于Python会默认打印出对象):

以>>>开头的行代表Python的输入(>>>是Python的默认提示符),其余行代表输出。在某些较长的代码样例中,如果没有显示程序的输出,那么为了清晰起见,我们会略去>>>。

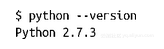

需要在命令行执行的样例会以Unix风格的“$”提示符开头:

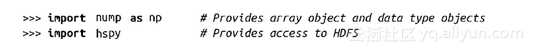

最后,为了避免样例过于冗杂,大多数代码都默认你已经导入了下面的模块:

2.2.3 NumPy

“NumPy”是世界公认的Python数值型数组模块。本书默认你已经有一定的NumPy经验(当然也包括Python的经验),包括如何使用数组对象。

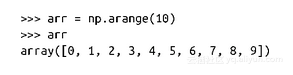

就算你以前用过NumPy,复习一下NumPy数组的一些基本概念还是有必要的。首先,所有的NumPy数组都有一个固定数据类型“dtype”,由dtype对象表示。下面的例子会创建一个具有10个整型元素的简单数组:

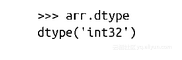

我们可以通过arr.dtype获得数组中数据的类型:

NumPy通过这些dtype对象来获取内存中数据的类型这种底层信息。本例中我们的10元素数组内的数据是4字节(32位)的整型,NumPy称其为int32。在内存的某处有一个40字节长度的区域保存了0到9这10个值。接收这个arr对象的代码可以根据其dtype属性解析这块内存中的实际内容。

提示

上例在你的系统可能打印出dtype(int64)。这意味着你系统中的Python默认的整型长度是64位而非32位。

HDF5使用了类似的类型系统。HDF5文件中每一个“数组”,也就是数据集,都有一个固定的类型对象表示其类型。h5py模块会自动将HDF5类型系统映射为NumPy的dtype,这使得两者之间的数据交换变得简便。第3章会详细介绍这一过程。

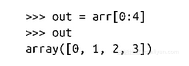

数组切片是NumPy的另一核心功能。这意味着可以对NumPy数组的局部进行访问。下例会抽取arr数组的前4个元素:

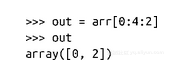

你还可以指定切片中每两个点之间的距离:

在使用HDF5时,我们也会借用这样的“切片”格式来读取一个数据集的部分数据。

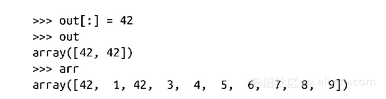

在NumPy的世界里,切片以一种高明的方式实现:新创建的数组引用原始数组中的数据而不是另外复制一份。比如,下面的out对象就是原始数组arr的一个视图,我们可以做这样的测试:

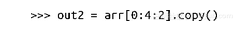

这意味着切片操作将会非常迅速。但如果你需要修改切片数组而又不希望这个修改影响原始数组时,就必须显式进行复制:

警告

忘记在修改切片数组前进行复制是一个常见的错误,尤其是对于那些习惯了IDL的人来说。如果你是NumPy新手,你需要特别小心!

幸好HDF5数据集的“切片”并不是这样。当你读取文件时,由于数据保存在磁盘上,你得到的始终是一个复制。

2.2.4 HDF5和h5py

我们将会通过“h5py”模块来使用HDF5。该模块包含了文件、组、数据集以及特征等HDF对象的上层封装类,同时还包含了HDF5的C语言数据结构和函数的底层封装类。本书中的样例假定h5py的版本是2.2.0或更高,你可以从 获取。

值得注意的是h5py并不是唯一一个跟HDF5打交道的常用模块。PyTables( )是一个基于HDF5的科学数据库模块并增加了数据集索引和额外的类型系统。不过我们这里只关注原生HDF5,所以我们将只讨论h5py,但我强烈推荐你去调查一下PyTables,看看它有没有什么吸引你的功能。

如果你使用Linux,最好用包管理器安装HDF5标准库。Windows上,你可以从 下载安装程序或下载某个自带HDF5/h5py的Python安装包,如PythonXY,Continuum Analytics公司提供的Anaconda,或者Enthought公司提供的Python安装包等。

2.2.5 IPython

如果你想用Python进行大规模分析或开发,那么除了NumPy和h5py/HDF5以外,IPython也是一个必需的组件。IPython最基本的功能是一个可以增添如命令历史和TAB补全等特性的解释器shell,可用于替换Python。除此之外它还具有如并发处理、MATLAB风格的记事本等很多额外的功能。

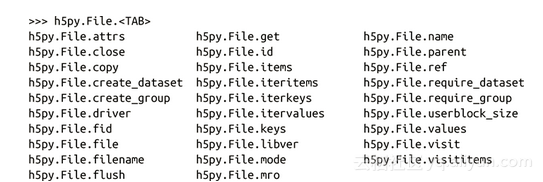

想要了解本书中所提到的特性最好的方法就是打开IPython提示符,然后输入本书的样例。光TAB补全这一个功能就很不错了,因为它能够让你快速查阅模块和对象的特征。h5py模块在设计上就充分考虑了这种可查阅能力。比如,如果你需要查看File对象上具有哪些属性和方法(2.4节),输入h5py.File,然后按TAB键:

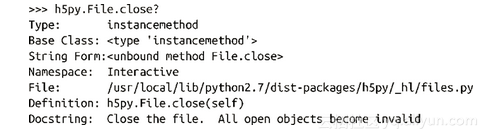

如果需要获得某个属性或方法更多的信息,只需要在其名字后面使用“?”即可:

提示

IPython默认会在一个特殊的隐藏变量中记录你语句的输出。一般来说这没什么问题,但是如果它记录了某个你认为已经丢弃的HDF5对象,或者一个耗费大量内存的大数组,那它也许就会让你大吃一惊。你可以将IPython的配置项cache_size设置为0来关闭这一功能。详情请见http://ipython.org中的文档。

2.2.6 时间和优化

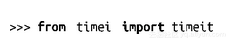

我们用Python内置的timeit模块来进行性能测试。相关样例会默认你已经导入了timeit模块,如下所示:

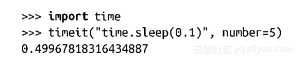

timeit函数需要一个可执行命令(字符串或可执行对象)和一个可选参数指定其运行次数。然后它会打印出执行该命令花费的总时间。在下面的例子里,我们将执行5次time.sleep:

IPython有一个类似的内建“魔法”函数%timeit,它可以多次执行给定的语句并报告最短执行时间:

考虑到普通的timeit函数是由Python标准库提供的,我们在本书中将只使用普通的timeit函数。

既然人们用HDF5处理的一般都是大数据集,那么性能就是一个不得不考虑的问题。不过你会注意到本书对于性能优化和性能测试的讨论将不会深入到缓存命中、数据转换率等细节。h5py模块的设计将所有这些细节都交给HDF5掌管。开发者们在HDF5性能调优上凝结了上千人几年的心血,已经达到了可能的极致。

作为一个应用程序开发者,在性能上你能做的最好的事就是明智地使用API并让HDF5来做背后的工作。下面是一些建议:

1.不要优化任何东西,除非存在可以验证的性能问题。在改变任何东西之前先仔细隔离可能导致错误行为的代码部分。

2.先从简单直观的代码开始,充分利用API提供的功能。比如,当你需要遍历一个文件中所有的对象时,应该使用HDF5的Visitor功能(63页,用Visitor模式多级遍历)而不是用你自己粗制滥造的方法。

3.首先考虑算法上的改进。比如,在写入一个数据集(见第3章)时,每次写入一个合理大小的块而不是一个值一个值地写。这使得HDF5可以充分利用文件系统。

4.确保你使用了正确的数据类型。比如你正在运行一个计算密集型程序,它的功能是从文件中读取浮点数,如果计算只要求单精度,那么你最好使用双精度浮点。

5.最后,勇于在h5py邮件列表、NumPy/Scipy邮件列表、Stack Overflow或别的社区网站上提问。这些年来已经有无数人在使用NumPy和HDF5,大多数的性能问题都有一个已知的解决方案。Python社区欢迎你。

转载地址:http://nfjix.baihongyu.com/